2012年,AlexNet横空出世。这个模型的名字来源于论文第一作者的姓名Alex Krizhevsky [1]。AlexNet使用了8层卷积神经网络,并以很大的优势赢得了ImageNet 2012图像识别挑战赛。

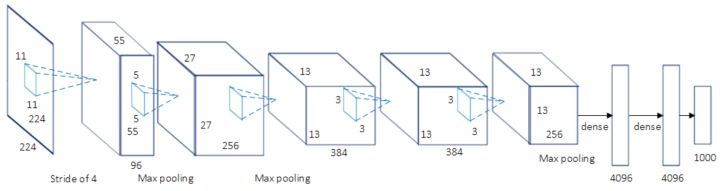

第一,与相对较小的LeNet相比,AlexNet包含8层变换,其中有5层卷积和2层全连接隐藏层,以及1个全连接输出层。

- AlexNet第一层中的卷积窗口形状是11×11,strides=4。因为ImageNet中绝大多数图像的高和宽均比MNIST图像的高和宽大10倍以上,ImageNet图像的物体占用更多的像素,所以需要更大的卷积窗口来捕获物体。

- 第二层中的卷积窗口形状减小到5×5;第三、四、五层的卷积窗口大小为3x3.

- 第一、第二和第五个卷积层之后都使用了窗口形状为3×3、步幅为2的最大池化层;而第三、四个卷积层之后没有池化层。

第二,AlexNet将sigmoid激活函数改成了更加简单的ReLU激活函数。

- 一方面,ReLU激活函数的计算更简单,例如它并没有sigmoid激活函数中的求幂运算。

- 另一方面,ReLU激活函数在不同的参数初始化方法下使模型更容易训练。这是由于当sigmoid激活函数输出极接近0或1时,这些区域的梯度几乎为0,从而造成反向传播无法继续更新部分模型参数;而ReLU激活函数在正区间的梯度恒为1。因此,若模型参数初始化不当,sigmoid函数可能在正区间得到几乎为0的梯度,从而令模型无法得到有效训练。

第三,AlexNet通过丢弃法来控制全连接层的模型复杂度。

第四,AlexNet引入了大量的图像增广,如翻转、裁剪和颜色变化,从而进一步扩大数据集来缓解过拟合。

参考:

《动手学深度学习》